- 1. 1.背景

- 2. 2.AIシステムがもたらす独特なリスク

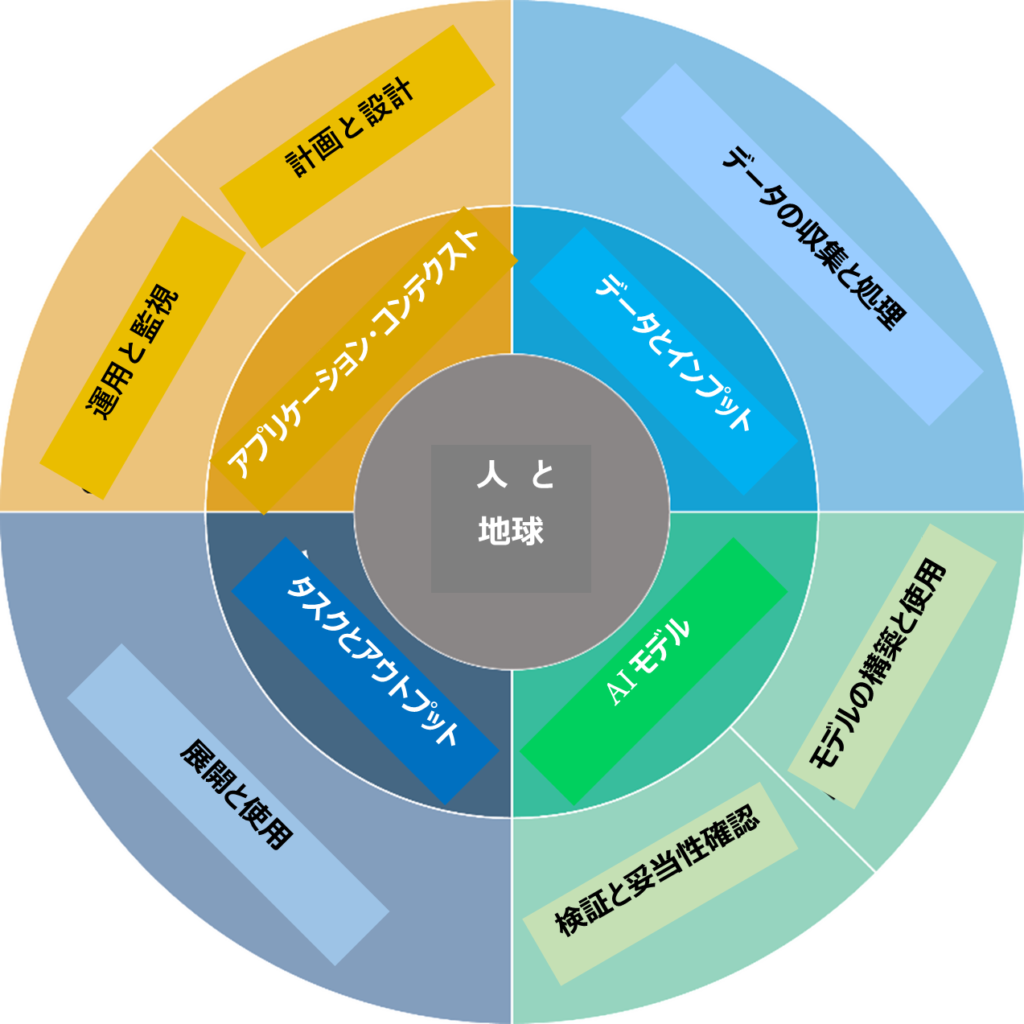

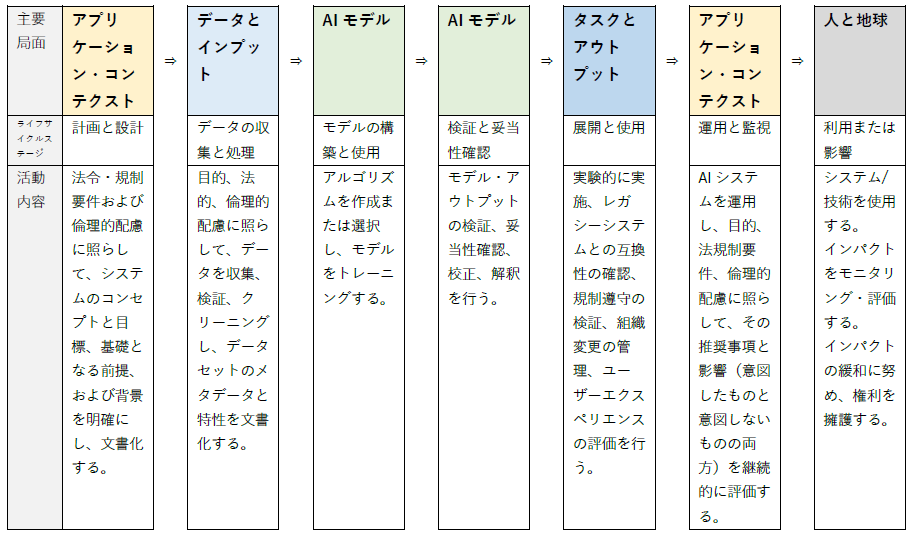

- 3. 3.AIシステムのライフサイクル

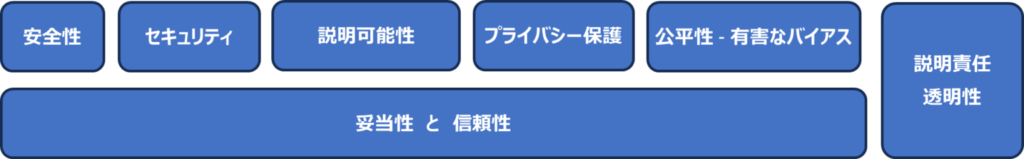

- 4. 4.AIリスクとトラストワージネス

- 4.1. 4-1.妥当性と信頼性(Valid and Reliable)

- 4.2. 4-2.安全性(Safe)

- 4.3. 4-3.セキュリティと回復力(Secure and Resilient)

- 4.4. 4-4.説明責任と透明性(Accountable and Transparent)

- 4.5. 4-5.説明可能性と解釈可能性(Explainable and Interpretable)

- 4.6. 4-6.プライバシー保護(Privacy-Enhanced)

- 4.7. 4-7.公平性 - 有害なバイアス管理(Fair – with Harmful Bias Managed)

筆者:(株)エヴァアビエーション 宮本 茂明

誰もが簡単に生成AIを利用できるようになり、「生成AIを使った、岸田首相のフェイク動画や俳優の政党支持に関する誤情報」をそのままSNSに投稿・拡散した事案が報道されています。

IT分野の一つとしての「AIツール」から生成AIが登場し、AI利用がもたらす社会的影響の大きさが加速・拡大し、AIが一つの社会基盤を構成する要素となりつつあるとすら感じます。事業者にとってもAIの利活用が不可欠なものとなってきていますが、AIの使い方を間違うとそれがリスクとなります。

AIの適切な利活用のためには、AIリスクをマネジメントしていく必要があります。このコラムでは、AIリスクをマネジメントするフレームワークの1つである「NIST AI RMF(リスクマネジメントフレームワーク)」の概要を、2回に分けて紹介します。

1.背景

2019年5月に、OECD加盟国で合意された「人工知能に関する理事会勧告」が公表されました。OECDのAI原則は、「包摂的な成長、持続可能な開発及び幸福、人間中心の価値観及び公平性、透明性及び説明可能性、頑健性、セキュリティ及び安全性、アカウンタビリティ」からなっています。OECD加盟各国はこの理事会勧告を受け、AI原則を実現するための取組みとして、AIガバナンスやリスクマネンジメントに関するガイドライン等の整備を進めています。

米国では、NISTが策定したAIシステムの設計、開発、展開、利用に関するリスクマネジメントフレームワークが「NIST AI RMF 1.0」として2023年1月に公開されました。

日本では、経済産業省が策定したAIシステム開発者・運用者のアジャイル・ガバナンスが「AI原則実践のためのガバナンス・ガイドライン V1.1」として2022年1月に公開されています。

また、ISO化も進行しており、ISO/IEC DIS 42001「AIマネジメントシステム」等の規格整備が進められています。

2.AIシステムがもたらす独特なリスク

AIシステムがもたらすリスクは多くの点で独特です。例えばAI システムは、時間の経過とともに予期せぬ形で大きく変化する可能性のあるデータを基に学習される可能性があり、利用者が理解するのが困難な形でシステムの機能や信頼性に影響を与えることが考えられます。AIシステムとそれを展開するコンテクスト(どういった目的で、どういった対象に、どう利用するか)は複雑であることが多く、障害が発生したときに、それを検知して対応することが難しい場合もあります。

AIシステムによる潜在的な危害をもたらすリスクの例として、以下のものがあります。

- 人への危害

- 個人: 個人の自由、権利、身体的・心理的安全、経済的機会への危害

- 集団/コミュニティ: ある集団に対する差別など、集団に対する危害

- 社会:民主主義への参加や教育へのアクセスに対する危害

- 組織への危害

- 組織の事業運営に対する危害

- セキュリティブリーチや金銭的損失による組織に対する危害

- 組織のレピュテーションに対する危害

- エコシステムへの危害

- 相互に関連し、依存し合っている要素やリソースに対する危害

- グローバルな金融システム、サプライチェーン、または相互に関連するシステムに対する危害

- 天然資源、環境、地球に対する危害

このようなリスクがあるため、AIは組織にとっても社会にとっても、展開と活用が非常に難しい技術となっています。適切なコントロールがなければ、AIシステムは個人やコミュニティにとって不公平で望ましくない結果を増幅、永続化、悪化させる可能性があります。

一方、適切にコントロールを行えば、AIシステムは不公平な結果を緩和し、より良い結果を生み出せるように管理することができるのではないでしょうか。

3.AIシステムのライフサイクル

AIリスクは、AIシステムのライフサイクル局面に応じ特定し、あわせてライフサイクル全体にわたる幅広い視点で管理していくことが必要です。以下にAIシステムのライフサイクルを示します。

このAIのライフサイクルは、OECDが公表しているライフサイクルをベースに「NIST AI RMF」の目的のために若干修正されたもので、AIのライフサイクル全体を通じてTEVV(Test, Evaluation, Verification, and Validation;テスト、評価、検証、妥当性確認)プロセスの重要性を強調し、AIシステムの運用のコンテクストを一般化したものになっています。

4.AIリスクとトラストワージネス

AIのトラストワージネス(trustworthiness)を高めるアプローチにより、AIの負のリスクを低減することができます。

トラストワージネスという用語は、「JIS X 22989:2023(ISO/IEC 22989:2022)人工知能の概念及び用語」で、“検証可能な方法でステークホルダーの期待を満たす能力”と定義されています。

NIST AI RMFでは、トラストワージネスの特性を以下のように明確にし、それらに対処するためのガイダンスを提供しています。

<トラストワージネスの特性>

4-1.妥当性と信頼性(Valid and Reliable)

展開されたAIシステムの妥当性と信頼性は、システムが意図したとおりに動作していることを確認する継続的なテストやモニタリングによって評価されます。妥当性、正確性、堅ろう性、信頼性の測定はトラストワージネスに寄与するものです。ある種の機能不全はより大きな危害をもたらす可能性があることを考慮に入れる必要があります。

AIリスクマネジメントの取組みは、潜在的な悪影響を最小化することを優先すべきで、AIシステムがエラーを検出又は修正できない場合には、人間の介入を含める必要があります。

4-2.安全性(Safe)

AIシステムは、定められた条件下で、人の生命、健康、財産、または環境が危険にさらされるような状態に陥ってはなりません。

ライフサイクルの中で安全性を考慮し、計画や設計をできるだけ早い段階から行うことで、システムを危険な状態に陥らせる可能性のある機能不全や状態を防ぐことができます。AIの安全性に関するその他の実用的なアプローチとしては、厳密なシミュレーションや領域内テスト、リアルタイムのモニタリング、意図された機能または期待された機能から逸脱したシステムをシャットダウンしたり、変更したり、人間が介入したりする能力に関するものがあります。

AIの安全性リスクマネジメントアプローチは、運輸や医療などの分野における安全への取り組みやガイドラインを参考にし、既存の分野や用途に特化したガイドラインや標準に合わせる必要があります。

4-3.セキュリティと回復力(Secure and Resilient)

一般的なセキュリティ上の懸念は、敵対的な事例、データポイズニング、AIモデルやトレーニングデータならびにその他の知的財産のエンドポイントからの流出に関するものです。

これらの懸念の元凶になる、認可されていないアクセスや利用を防止する保護メカニズムによって機密性、完全性、可用性を維持できるAIシステムはセキュアであると言えます。

セキュリティと回復力は関連していますが、異なる特性です。回復力は、予期しない不利な事象が発生した後でも正常な機能に復帰する能力のことです。セキュリティには回復力も含まれますが、攻撃を回避、防御、対応、回復するためのプロトコルも含まれます。回復力は堅ろう性に関連し、データの出所にとどまらず、モデルやデータの予期せぬ使用や敵対的な使用(あるいは悪用や誤用)からの回復も含まれます。

4-4.説明責任と透明性(Accountable and Transparent)

信頼できるAIは説明責任に依存します。説明責任は透明性を前提とします。透明性とは、AIシステムとそのアウトプットに関する情報が、そのようなシステムと相互作用する個人にとって、どの程度利用可能であるかを反映したものです。

この特性の範囲は、設計上の意思決定やトレーニングデータから、モデルのトレーニング、モデルの構造、意図されたユースケース、展開、展開後、またはエンドユーザーの意思決定が、いつ、どのように、誰によって行われたかにまで及びます。トレーニングデータの量や質がAIシステムの性能に大きく影響するため、AIシステムに適切なトレーニングデータを与える必要があります。トレーニングデータの出所を管理し、AIシステムの判断がトレーニングデータのサブセットに起因することを管理することにより、透明性と説明責任の両方をサポートすることができます。

4-5.説明可能性と解釈可能性(Explainable and Interpretable)

説明可能性とは、AIシステムの動作の基礎となるメカニズムを表し、解釈可能性とは、AIシステムのアウトプットが、その設計された機能目的のコンテクストでどのような意味を持つかということです。

透明性、説明可能性、解釈可能性は、互いに支え合う明確な特性です。透明性は、システムで「何が起こったか」という疑問に答えることができ、説明可能性は、システムにおいて「どのように」決定がなされたかという疑問に答えることができ、解釈可能性は、システムによって「なぜ」決定がなされたのか、そしてその決定がユーザーにとってどのような意味やコンテクストを持っているのかという疑問に答えることができます。

4-6.プライバシー保護(Privacy-Enhanced)

一般的に、匿名性、機密性といったプライバシーに関する価値観は、AIシステムの設計、開発、展開における選択の指針となるべきです。プライバシーに関連するリスクは、セキュリティ、バイアス、透明性に影響を与える可能性があり、これらの他の特性とのトレードオフを伴います。安全性やセキュリティと同様に、AIシステムの特定の技術的特性は、プライバシーを強化することもあれば、低下させることもあります。

AIシステムはまた、推論によって個人を特定したり、個人に関する非公開情報を特定したりすることで、プライバシーに新たなリスクをもたらす可能性もあります。

4-7.公平性 - 有害なバイアス管理(Fair – with Harmful Bias Managed)

AIにおける公平性には、有害なバイアスや差別といった問題に対処することで、公平性に加えて平等性にも配慮することが含まれます。公平性の基準は複雑であり、定義することが困難な場合があります。なぜなら、公平性に対する認識は文化によって異なり、用途によって変化する可能性があるからです。このような違いを認識し考慮することで、組織のリスクマネジメントの取り組みは強化されます。

バイアスは様々な形で存在し、私たちの生活に関する意思決定を支援するシステムに意図せずに根付く可能性があります。バイアスは必ずしも否定的な現象ではありませんが、AIシステムはバイアスのスピードと規模を増大させ、個人、グループ、コミュニティ、組織、社会に対する危害を永続化させ、増幅させる可能性があります。 以上が、NIST AI RMFの背景、AIリスクとトラストワージネスの概要です。次回のコラムでは、AIのリスクマネジメントフレームワークの概要を紹介します。

【 参考情報 】

- 「人工知能に関する理事会勧告」Recommendation of the Council on OECD Legal Instruments Artificial Intelligence

https://legalinstruments.oecd.org/en/instruments/OECD-LEGAL-0449 - OECD Framework for the Classification of AI Systems: a tool for effective AI policies

https://oecd.ai/en/classification - NIST AI RMF

https://www.nist.gov/itl/ai-risk-management-framework - 経済産業省「AIガバナンス」

https://www.meti.go.jp/policy/it_policy/ai-governance/index.html